꾸준함이 실력입니다.

One Two be super Developer-

HTTP를 사용한 특정 범위 요청 : 서버에게 특정 범위를 요구하다.

이 글의 개념 및 코드들은 책을 읽으며 정리한 내용을 바탕으로 작성하였습니다.

문제 상황

-

일반적으로 클라이언트 -> 서버로 요청 시

-

문서 전체를 응답하거나 아예 응답하지 않거나 All or Nothing으로 응답한다.

-

하지만 특정 범위만 요구해야할 필요가 있을 수 있다.

-

예를 들어보자.

파일을 다운로드 받는데 1분이 필요하다 가정을 해보자. 유저가 59초동안 다운을 받다가 네트워크 커넥션의 장애로 인해 중간에 연결이 끊겼다. 그렇다면 다시 1분을 소요하여 다운받는게 합리적일까? 그렇지 않다. 1초동안 받지 못한 데이터에 대해서만 받는게 가장 합리적이다.-

이런 상황에서 보다 합리적인 요청을 위해서

-

HTTP는 클라이언트가 문서의 일부분이나 특정 범위만 요청할 수 있도록 해준다.

-

-

2020 1Q Blog 기록하기

Prologue

-

운영중인 블로그에 대한 정리를 하고 싶어졌다.

-

그동안 매일 블로그 변화를 체크하기 위해서

-

아침마다 GA(=Google Analytics)에서 눈으로 보기만 했지 따로 기록을 하진 않았다.

-

나에게 있어서 블로그는 매우 큰 가치가 있다.

-

내가 공부하는 모든 것들을 남기는 곳이며

-

그 과정 속에서 공부했구나 라는 정신 승리가 이뤄지는 곳이기 때문이다.

-

그리고 그렇게 몇 년 동안 블로그를 운영하다 보니 이제는 내 분신과 같은 존재가 되어버렸다.

-

그런 맥락 속에서

-

어찌보면 나의 성장을 지표화하고 객관화 할 수 있는 요소가

-

블로그의 성장이지 않을까?라는 생각이 들었고

-

그렇기 때문에 블로그의 변화에 대해 기록을 남기고 싶어졌다.

-

마치 블로그가 성장하면 나의 실력도 같이 성장하지 않았을까?라는 이상한 논리일 수도 있다.

-

-

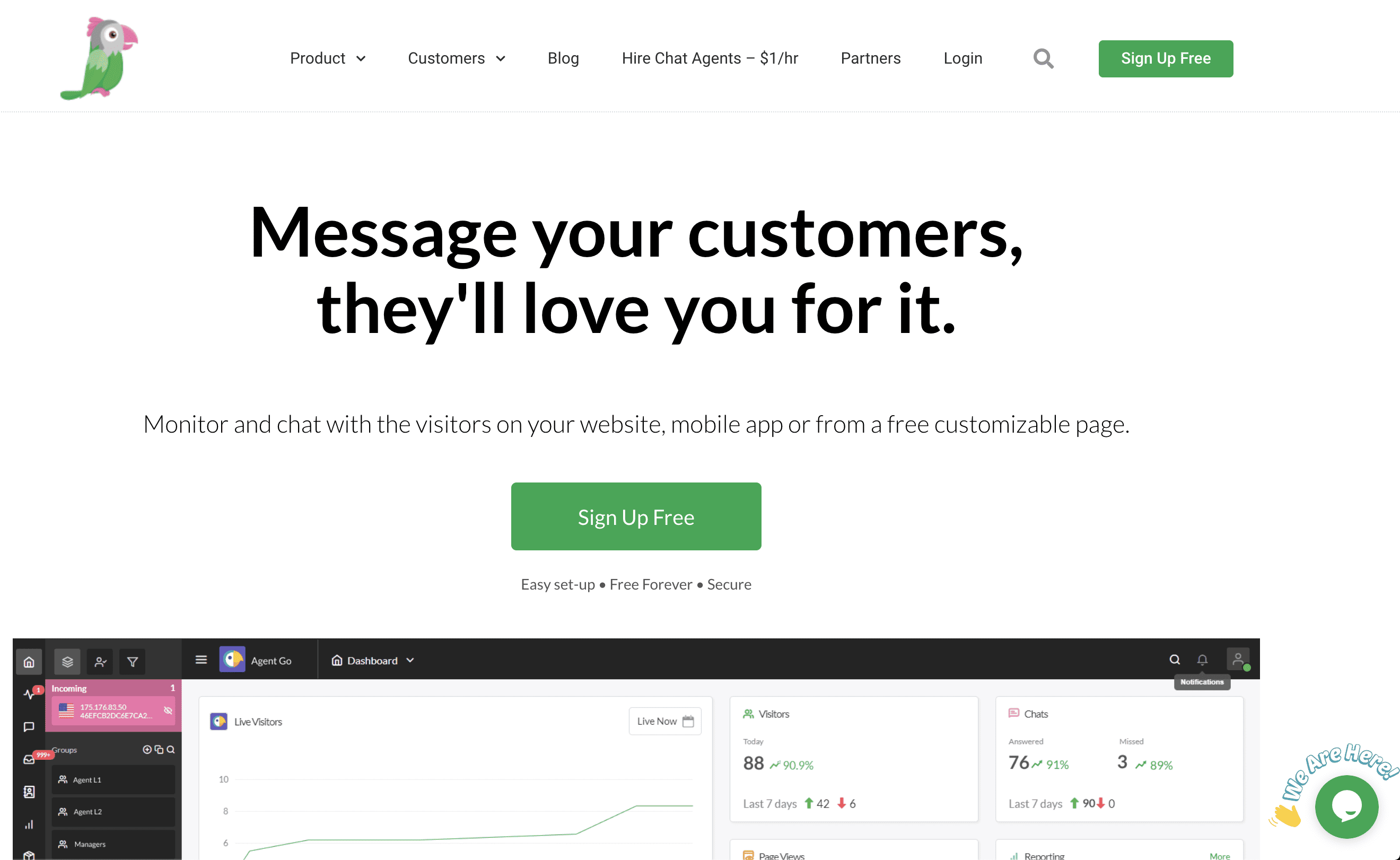

Tawk.to 서비스 적용 및 알아보기

Tawk.to

-

Tawk.to 라는 서비스를 블로그에 추가하였다.

-

Tawk.to 서비스의 핵심 기능은 유저랑 블로거와 Live 채팅 기능이다.

-

그리고 사용자 입장에서는 번거롭게 로그인을 하지 않아도 되기 때문에 무척이나 편리하단 생각이 든다.

-

-

HTTP 인증 : 기본 인증

이 글의 개념 및 코드들은 책을 읽으며 정리한 내용을 바탕으로 작성하였습니다.

인증 프로토콜

-

HTTP에는 기본 인증과 다이제스트 인증이라는 2가지 공식적인 인증 프로토콜이 있다.

-

이 글에서는 기본 인증에 대해서 알아본다.

-

다이제스트 인증은 다른 자료를 참고하도록 하자.

-

-

웹 로봇(Web Robots)에 대해 알아보기 : robots.txt

이 글의 개념 및 코드들은 책을 읽으며 정리한 내용을 바탕으로 작성하였습니다.

웹 로봇

-

1994년 웹 마스터에게

-

로봇의 동작을 더 잘 제어할 수 있는 메커니즘을 제공하는 단순하고 자발적인 기법이 제안되었다.

-

이 표준은 Robots Exclusion Standard 라고 이름이 지어졌다.

-

그리고 로봇의 접근을 제어하는 정보를 저장하는 파일의 이름을 따서 robots.txt라고 부른다.

-

웹 서버는 서버의 문서 루트에 robots.txt 파일을 제공한다.

-

이 파일은 웹 로봇이 서버의 어떤 부분에 접근할 수 있는지에 대한 정보가 담겨있다.

-

만약 웹 로봇이 표준을 따른다면

-

웹 사이트의 리소스에 접근하기전에 우선 사이트의 robots.txt를 요청할 것이다.

robots.txt 가져오기

-

웹 로봇은 HTTP GET 메소드를 이용해 robots.txt를 가져온다.

-

해당 서버에 robots.txt가 존재한다면 text/plain 본문으로 반환한다.

-

만약 서버가 404 NOT Found HTTP를 반환한다면

-

로봇은 접근을 제한하지 않는 것으로 간주하고 모든 리소스를 요청한다.

-

로봇은 사이트 관리자가 접근을 추적할 수 있도록

-

From이나 User-Agent 헤더를 통해 신원 정보를 넘기고

-

사이트 관리자가 로봇에 대해 문의나 불만사항이 있을 경우를 위해 연락처를 제공해야한다.

응답 코드

- 로봇은 robots.txt의 검색 결과에 따라 다르게 동작한다.

-

-

HTTP 완벽 가이드 요약본 : 7장 캐시

이 글의 개념 및 코드들은 책을 읽으며 정리한 내용을 바탕으로 작성하였습니다.

Prologue

-

HTTP 완벽 가이드 책을 보면서

-

포스팅 하기엔 너무 가볍지만

-

내가 알지 못했던 부분들을 정리하기 위해 작성하는 글이다.

-

- Cursor가 매일 수십억 건의 AI 코드 완성을 처리하는 방식

- A 레코드와 CNAME 레코드는 뭐가 다른걸까?

- 분산 시스템에서 순서가 보장되지 않은 이벤트를 다루는 전략

- DU(Disk Usage) 명령어를 아시나요?

- 2PC(Two-Phase Commit)란 무엇일까?

- DIG(Domain Information Groper) 명령어를 아시나요?

- 샤딩과 파티셔닝, 그 차이에 대하여

- LeetCode : 692. Top K Frequent Words

- Redis 서버에 접속중인 Client 목록 확인 방법

- LeetCode : 1299. Replace Elements with Greatest Element on Right Side

- Conference 11

- AlgorithmSkill 39

- DB 24

- Algorithm 175

- Crawling 1

- Node.js 15

- Linux 6

- AWS 11

- E.T.C 51

- Competition 5

- Python 26

- BlockChain 36

- MachineLearning 19

- 파일처리 14

- OS 12

- Server 31

- Docker 1

- Web 1

- JavaScript 18

- Network 39

- Git 6

- Technology 64

- DataStructure 1

- C/C++ 1

- HTTP 14

- Java 38

- Redis 9

- Retrospective 7

- Spring 72

- SpringBoot 16

- Kafka 26

- CleanCode 12

- TIL 4

- Blog 7

- Nginx 6

- MyBatis 6

- Regex 4

- EffectiveJava 2

- Spock 1

- Junit5 4

- Intellij 1

- CLI 1

- LeetCode 203

- MySQL 1

- JavaOptimizing 6

- Feign 1

- Karate 2

- Github 8

- SystemDesign 23

- Gradle 3

- Logback 3

- Kotlin 7

- CleanArchitecture 6

- Tech 6